它是AI高带宽内存的首选芯片,但却离不开国产先进技术赋能

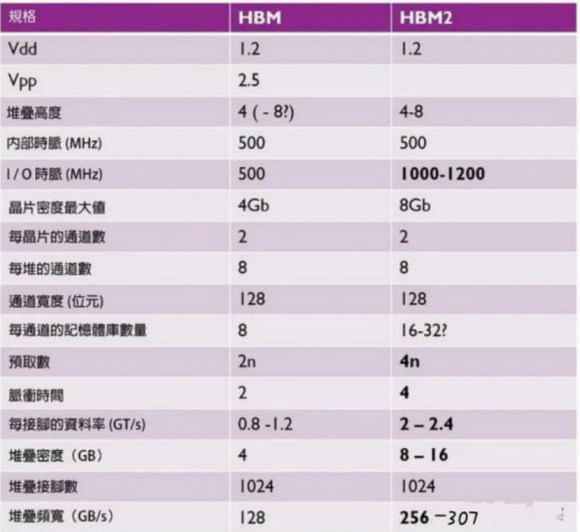

显卡的显存这一路走来都是GDDR,但是这两年HBM成了大明星,最新的HBM2E显存也在去年8月首次提出规格。

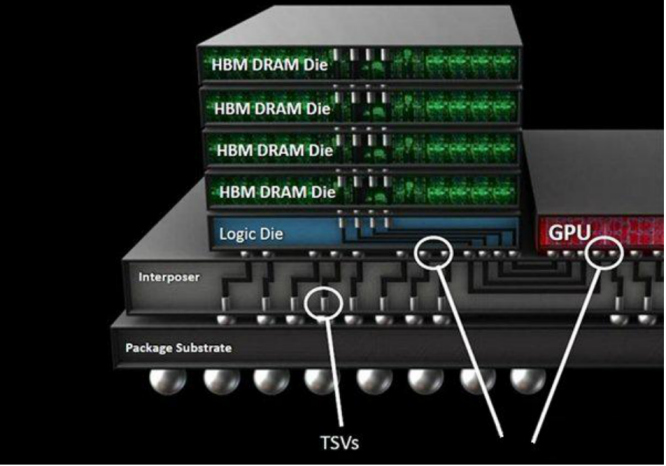

由于三星等公司的努力,HBM在过去几年来逐渐展现稳步成长。例如三星上半年发布了称为“Flashbolt”的第三代16GB HBM2E,在HBM2E封装上的缓冲芯片顶部垂直堆栈8层10nm级(1y)16Gb DRAM芯片,使其前一代的“Aquabolt”容量提高了一倍。其HBM2E封装以40,000多个TSV微凸块排列方式互连,同时提供3.2Gbps的数据传输速度,每堆栈内存带宽为410Gbps。

HBM持续进展离不开IP共同生态

HBM作为开放标准,任何人都可用于开发产品,而且也开始在超大规模业者与AI应用中探索更多需求,而不仅仅是最初的HPC和高阶绘图系统。它带来了比DDR更高速的连接方式,显然已经成为AI的首选内存。后期还将持续进展以满足高带宽的需求,但这也离不开IP等合作伙伴共同发展生态系统。

国内就已有IP供应商在HBM技术上与多家Foundry建立了合作生态,例如芯动科技,在先进技术上紧跟国际潮流,加快追赶步伐。是目前国内唯一与六大顶尖半导体厂建立合作生态的IP供应商,其推出的HBM2E满足国际通用标准,看齐国际最先进水平。

价格昂贵的HBM终将迎来规模化需求

即使AI和超大规模业者开启了HBM需求之门,相对而言仍算是小量制造。这并不至于让其大量普及,因为它仍然是一种价格非常昂贵的解决方案。但是随着量更大以及更多应用导入,规模经济也会显现,毕竟HBM的带宽吞吐量是无与伦比的。

三星自2016年推出Flarebolt迭代以及接着在2018年推出第二代HBM2——即Aquabolt以来,一直在稳定地逐步改善其HBM产品。以其最新的HBM2E产品来看,速度基本上可以提高到75%,并较上一代产品的容量增加了1倍。此外,HBM可说是目前最快的DRAM形式,对于为AI和机器学习应用寻找理想解决方案的客户而言极具吸引力。此外,自动驾驶应用也着眼于导入这项技术,以支持所需的实时决策。